deepep是一个专注于提升计算效率的开源工具,特别适合用于MoE模型的训练和推理。它采用了EP通信库,通过NVLink和RDMA支持节点间和节点内的高速通信,确保数据在各个处理单元间快速流动,减少延迟。这个技术的优势在于它可以同时处理大量的计算任务,使用高量内核来进行预填充计算,同时通过低延迟内核来优化推理解码过程,提升整体效率。deepep还原生支持FP8调度,能更好地控制GPU资源,提高计算性能,最大限度地减少计算和通信之间的空隙。通过这些创新的优化手段,deepep能显著加速训练过程并提升推理速度,适用于需要高效计算的各种深度学习任务。

软件简介

DeepEP是DeepSeek推出的高效通信库,专门为MoE和EP场景设计,旨在提升分布式系统中大规模AI训练和推理的效率。这个开源库通过提供高吞吐量和低延迟的GPU内核,解决了传统MoE模型在分布式计算中常见的通信瓶颈,显著加速了数据传输和计算过程。DeepEP原生支持FP8低精度计算,这种8位浮点格式在深度学习中被广泛使用,因为它不仅能减少内存占用和计算负担,还能保持较高的模型精度。通过优化通信协议与计算内核,DeepEP极大降低了内存和通信开销,提高了系统的整体效率。此外,DeepEP的设计充分考虑了硬件加速,利用低精度计算技术优化GPU和FPGA等硬件的性能,从而大幅提升了训练速度。它还支持跨平台部署,能够在不同的硬件架构和操作系统上运行,方便在各种计算环境中应用。作为一个开源项目,DeepEP鼓励社区贡献与共享,促进了AI技术的创新与进步,使得更多研究者和开发者能够快速使用并改进这一工具,推动了高性能计算在AI领域的广泛应用。

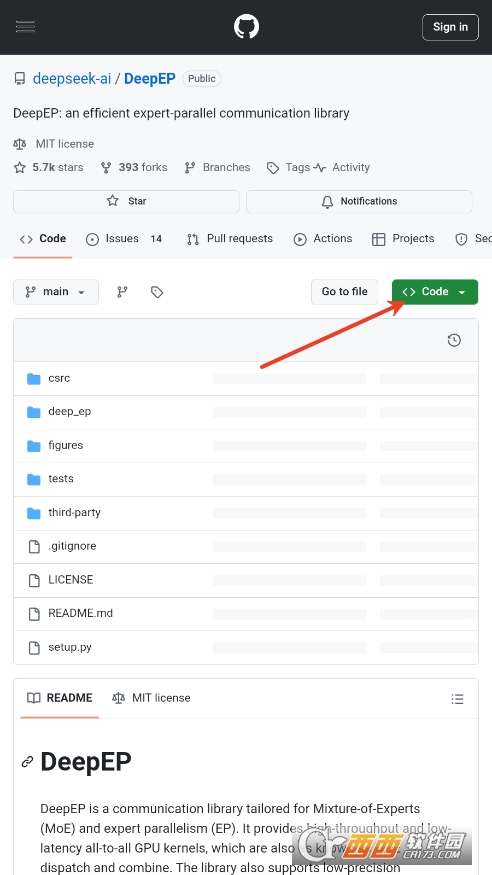

DeepEP打开查看功能

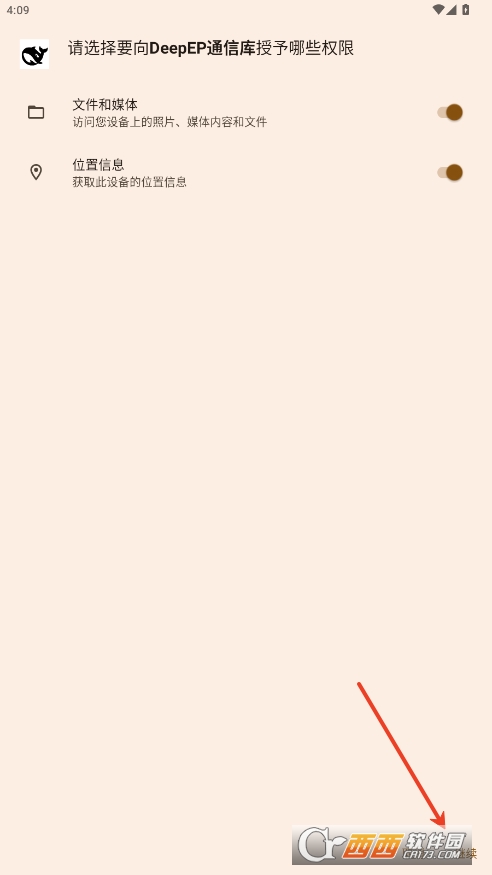

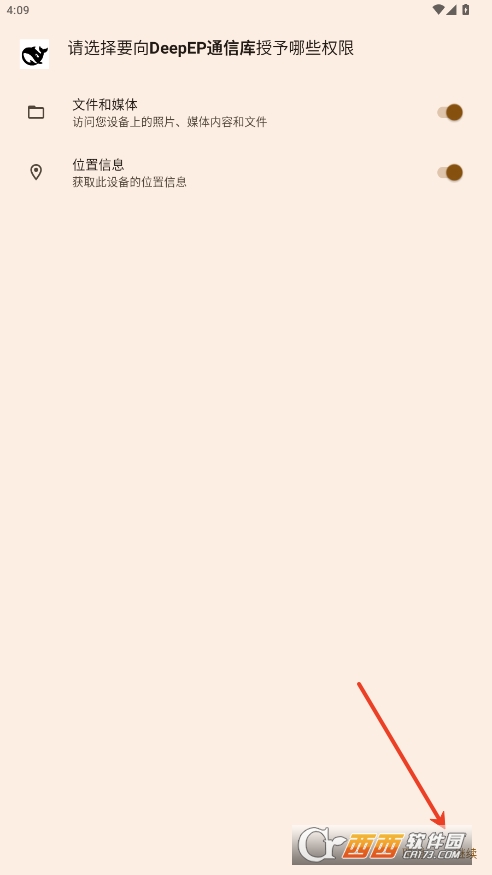

首先打开APP需要给它权限

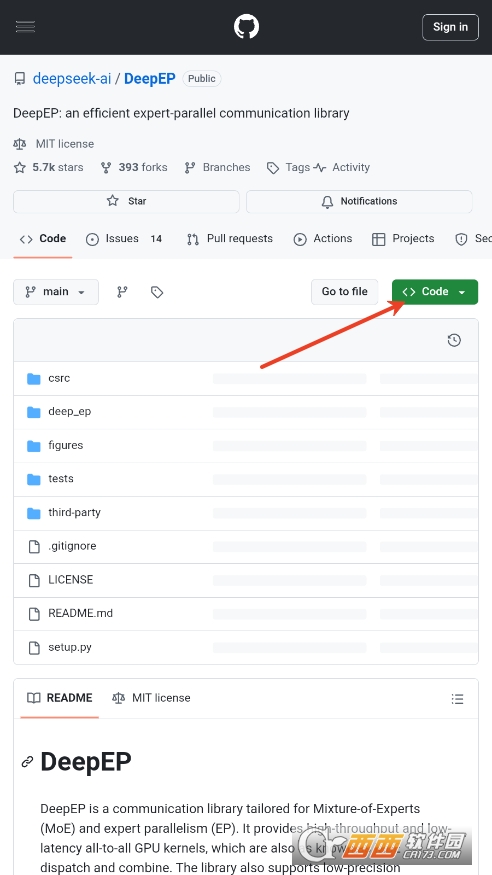

我们可以直接下载代码到设备上

DeepEP技术优势

(一)突破通信瓶颈,加速数据流转

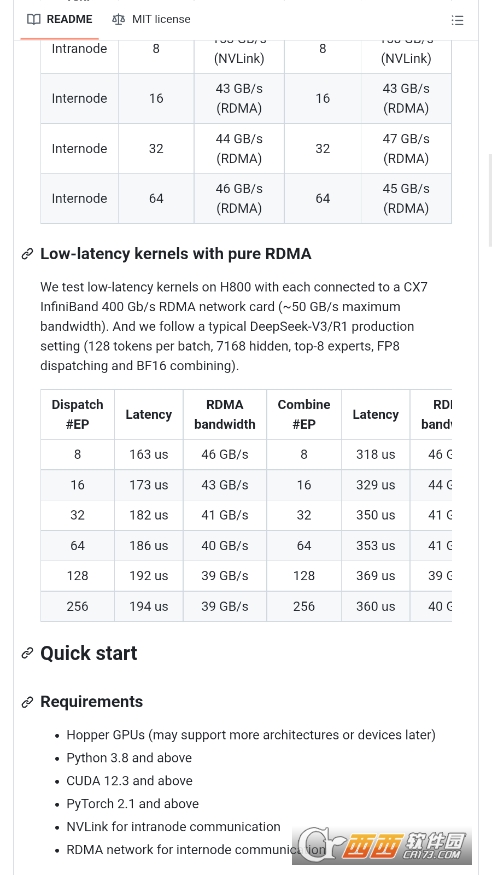

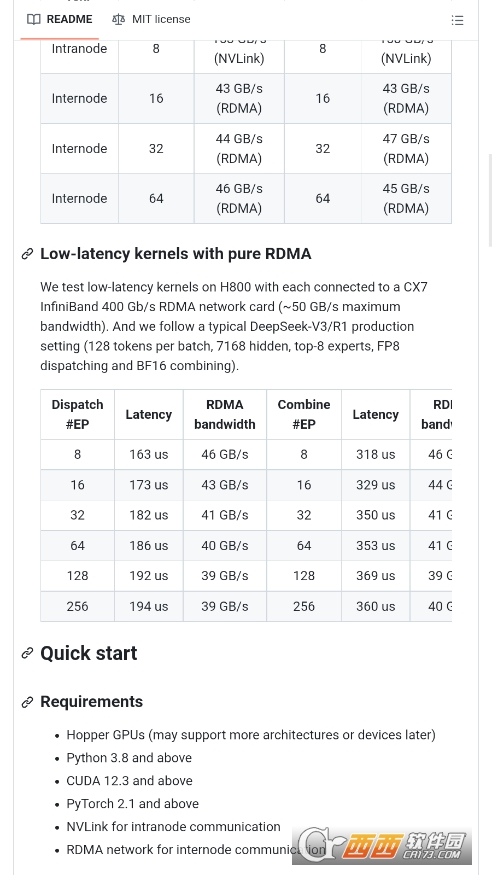

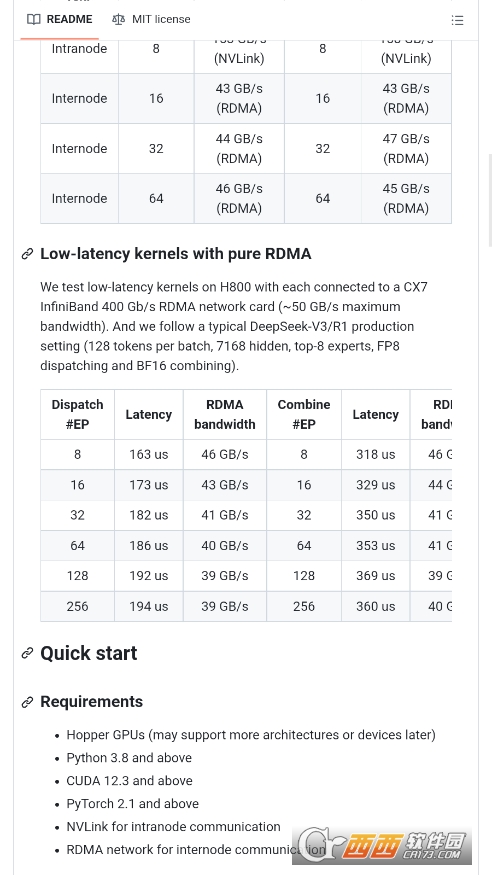

在分布式系统的大规模 AI 训练和推理场景中,传统 MoE 模型常常受困于通信瓶颈,导致数据传输缓慢,严重影响计算效率。DeepEP 的出现犹如一道曙光,它精心打造的高吞吐量和低延迟的 GPU 内核,成为解决这一难题的关键。通过优化通信协议,DeepEP 能够让数据在各个节点间如高速列车般快速流动。在多节点协同训练一个超大规模语言模型时,DeepEP 能够确保每个节点的计算结果和中间数据迅速传输到其他节点,减少等待时间,使得整个分布式计算过程更加流畅高效,大大缩短了大规模 AI 训练和推理所需的时间。

(二)FP8 低精度计算的卓越应用

DeepEP 原生支持 FP8 低精度计算,这一特性在深度学习领域具有重大意义。在深度学习模型中,数据的存储和计算占用了大量内存和计算资源。而 FP8 这种 8 位浮点格式,就像一位精打细算的管家,在保证模型精度不受太大影响的前提下,巧妙地减少了内存占用和计算负担。以图像识别模型为例,使用 FP8 计算后,模型在训练和推理过程中所需的内存大幅降低,同时计算速度得到提升,使得在资源有限的情况下,也能高效地运行复杂的 AI 模型。通过对 FP8 计算的优化,DeepEP 进一步提升了计算内核的性能,降低了内存和通信开销,为系统整体效率的提升做出了巨大贡献。

(三)硬件加速与跨平台部署

DeepEP 的设计充分挖掘了硬件的潜力,利用低精度计算技术对 GPU 和 FPGA 等硬件进行性能优化。它就像一位硬件魔法师,让硬件在 AI 计算中发挥出最大效能。在 GPU 上,DeepEP 通过优化计算内核,使得 GPU 的并行计算能力得到充分释放,加速了矩阵运算等关键操作,从而显著提升训练速度。同时,DeepEP 支持跨平台部署,无论是在常见的 x86 架构服务器上,还是在基于 ARM 架构的移动设备或嵌入式系统中,亦或是不同的操作系统如 Linux、Windows 等,DeepEP 都能稳定运行,为各种计算环境下的 AI 开发者和研究者提供了极大的便利,让高性能计算在 AI 领域得以广泛应用。

二、开源生态与社区价值

(一)开源共享促进创新

作为一个开源项目,DeepEP 为全球的 AI 研究者和开发者打开了一扇通往高效计算的大门。它鼓励社区成员积极贡献代码、分享经验和提出改进建议。在这个开源社区中,不同背景的专业人士汇聚一堂,各自发挥专长。有的开发者专注于优化通信内核,进一步提升数据传输速度;有的研究者则致力于改进 FP8 计算在特定模型中的应用,提高模型的精度和效率。这种开源共享的模式,使得 DeepEP 能够不断进化,推动 AI 技术的持续创新,让更多人能够受益于高效的 AI 计算技术。

(二)降低技术门槛,推动行业发展

DeepEP 的开源性质大大降低了使用高性能计算技术进行 AI 开发的门槛。以往,开发者可能需要花费大量时间和精力去开发自己的通信库和优化计算内核,而现在,有了 DeepEP 这个现成的工具,开发者可以将更多的精力投入到模型的创新和应用的开发中。对于一些资源有限的研究团队或初创企业来说,DeepEP 提供了一个低成本、高效能的解决方案,使得他们能够在 AI 领域迅速开展研究和开发工作,推动整个 AI 行业的快速发展。

如何在自己的 AI 项目中快速集成 DeepEP?

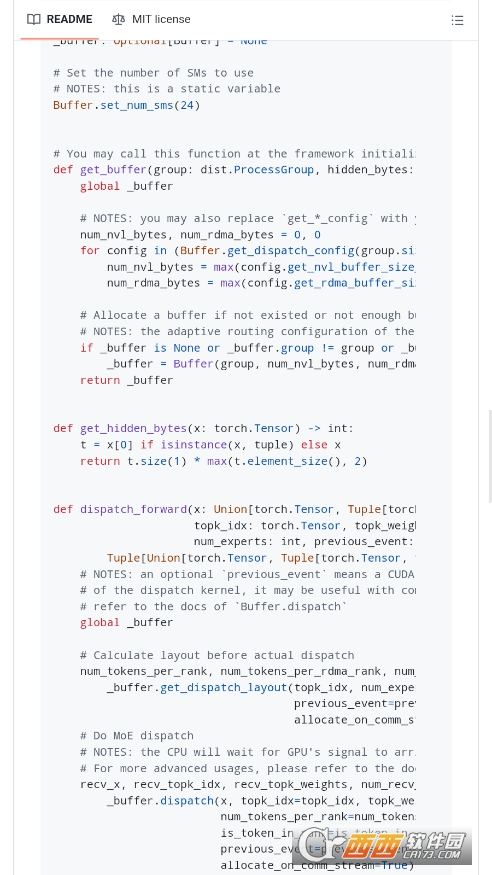

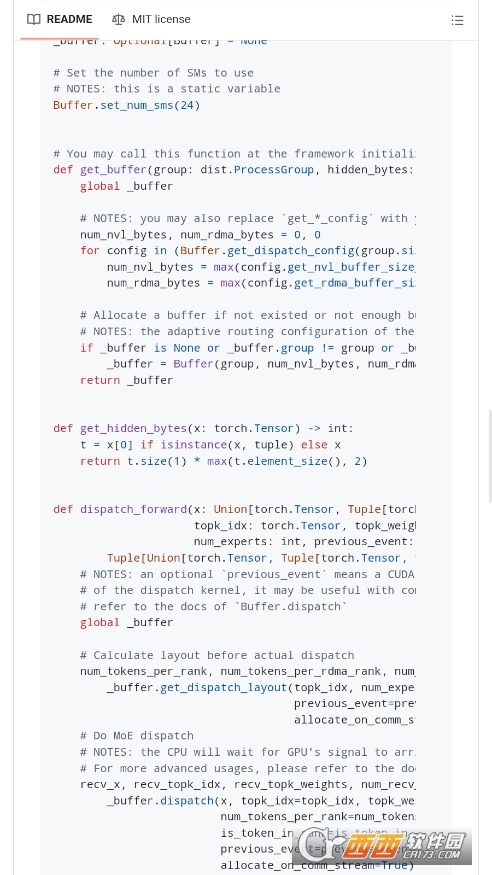

首先,确保你的开发环境满足 DeepEP 的依赖要求,包括合适的 GPU 驱动、CUDA 版本等。从 DeepEP 的官方开源代码库(如 GitHub)下载最新版本的代码。解压代码包后,进入项目目录,根据官方文档中的构建指南,使用相应的构建工具(如 CMake)进行编译。在编译过程中,注意配置与你的硬件环境和项目需求相匹配的参数,例如是否启用特定的硬件加速功能、选择合适的 FP8 计算模式等。编译完成后,将生成的库文件和头文件正确链接到你的 AI 项目中。在项目代码中,按照 DeepEP 的 API 文档,引入相应的头文件,并调用相关函数来初始化通信环境、设置计算参数等。例如,在使用 DeepEP 进行分布式训练时,通过调用特定函数来创建通信组,配置节点间的通信方式,确保数据能够在不同节点间正确传输。通过这些步骤,就可以在自己的 AI 项目中快速集成 DeepEP,享受其带来的高效计算能力。

当在使用 DeepEP 时遇到性能瓶颈,如何进行排查和优化?

如果在使用 DeepEP 时发现性能未达到预期,首先检查硬件资源的使用情况。使用系统监控工具(如 nvidia - smi 查看 GPU 使用情况),查看 GPU 是否存在资源闲置或过度占用的情况。若 GPU 资源利用率低,检查代码中是否正确配置了 DeepEP 的并行计算参数,例如是否充分利用了 GPU 的多核心进行计算。接着,检查通信方面的设置。查看节点间的网络连接状况,确保网络带宽足够,没有出现网络拥堵。在 DeepEP 的配置中,检查通信协议的选择是否合适,例如对于高速网络环境,是否选择了最优的 RDMA 通信协议。如果使用了 FP8 计算,检查 FP8 的调度和计算参数是否合理。尝试调整 FP8 的精度级别或计算模式,观察性能是否有所改善。还可以参考 DeepEP 的官方文档和社区论坛,查看是否有其他用户遇到类似问题及解决方案,通过这些方法逐步排查和优化,提升 DeepEP 在项目中的性能表现。

中文名:DeepEP通信库

包名:com.deepep.ai

MD5值:f885f5e9ad0c1f9b25592b26a970b422

大小: 11.4M

大小: 11.4M

腾讯微视appv8.127.0.589官方安卓版

腾讯微视appv8.127.0.589官方安卓版  联通手机营业厅(中国联通)v11.5.1方最新版

联通手机营业厅(中国联通)v11.5.1方最新版  4399游戏盒安全版v9.2.0.47官方安卓版

4399游戏盒安全版v9.2.0.47官方安卓版  HDP直播tv版v3.3.7 正式版

HDP直播tv版v3.3.7 正式版  手机qq2025最新版v9.0.71 官方正式版

手机qq2025最新版v9.0.71 官方正式版  中华万年历日历app(微鲤万年历)v9.1.9官方安卓版

中华万年历日历app(微鲤万年历)v9.1.9官方安卓版  谷歌卫星地图google earth下载2025最新版v10.94.0.3中文免费版

谷歌卫星地图google earth下载2025最新版v10.94.0.3中文免费版  萤石云视频6.15.2.240428安卓版

萤石云视频6.15.2.240428安卓版  中国移动手机营业厅V11.5.0官方安卓版

中国移动手机营业厅V11.5.0官方安卓版  方正手迹造字2025版v5.7.1最新版

方正手迹造字2025版v5.7.1最新版  PP助手app手机版V8.5.5.0官方手机版

PP助手app手机版V8.5.5.0官方手机版  QQ输入法V8.7.5官方正式版

QQ输入法V8.7.5官方正式版  凯立德手机导航软件V8.4.13 官方最新版

凯立德手机导航软件V8.4.13 官方最新版  安卓市场HiMarket7.8.1.81 官方正式版

安卓市场HiMarket7.8.1.81 官方正式版  Adobe AIR for Androidv25.0.0.134 安卓版

Adobe AIR for Androidv25.0.0.134 安卓版  hao123上网导航手机版V5.13.0.50 安卓版

hao123上网导航手机版V5.13.0.50 安卓版  360免费wifi手机版V8.1.8官方最新版

360免费wifi手机版V8.1.8官方最新版  小米电视助手投屏神器V2.7.6 官方版

小米电视助手投屏神器V2.7.6 官方版  和彩云网盘(中国移动云盘)mcloud11.1.0 官方版

和彩云网盘(中国移动云盘)mcloud11.1.0 官方版  微双开分身多开宝appv10.2.6.0 安卓版

微双开分身多开宝appv10.2.6.0 安卓版  谷歌拼音输入法V4.5.2.193126728-armeabi-7a 安卓版

谷歌拼音输入法V4.5.2.193126728-armeabi-7a 安卓版